Deepfake: los videos que parecen reales, pero no lo son

Los 'deepfake' son videos que reemplazan el rostro de una persona por otro completamente diferente, mediante técnicas de inteligencia artificial.

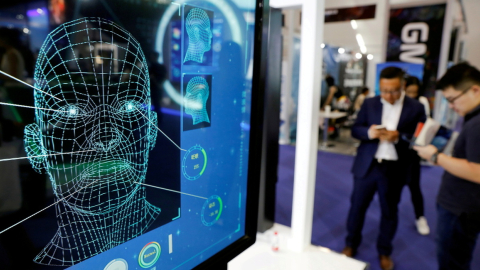

Computadora muestra un rostro en vectores, reconocimiento facial.

Reuters

Autor:

Actualizada:

Compartir:

El término 'deepfake' se acuñó en 2017 tras ventilarse unos videos manipulados de Taylor Swift y Gal Gadot en los cuerpos de actrices porno.

Estos videos falsos son recreados mediante técnicas de inteligencia artificial, que reconocen el rostro de una persona y lo superpone en la de otra. Actualmente, se pueden hacer incluso a través de una aplicación.

Pero, el uso de los videos 'deepfake' no siempre es negativo, según explica Idoia Salazar, presidenta y cofundadora del Observatorio del Impacto Ético y Social de la Inteligencia Artificial.

Aunque en las manos equivocadas, pueden convertirse en una herramienta para desinformar de una forma mucho más sofisticada.

Por ejemplo, un usuario puede poner palabras en la boca de un presidente que inviten al desorden público, o desprestigiar a activistas a través de videos pornográficos.

Salazar explica que cuando una persona ve algo por escrito puede intuir por la tipografía que es un contenido modificado, pero cuando una persona ve una imagen que se mueve y se expresa con naturalidad "se lo va a creer casi seguro".

En el siguiente video, PRIMICIAS le explica cómo funciona la tecnología detrás de estos videos.

Crecimiento exponencial

La empresa Sentinel identificó un crecimiento del 900% de los videos 'deepfake' desde 2019. La mayoría se compartió a través de redes sociales y tuvieron cerca de 6.000 millones de visualizaciones.

Esta tecnología, que apenas tiene cuatro años, puede estar en un momento crucial, según las entrevistas de Reuters con empresas, investigadores, responsables políticos y activistas.

Según los expertos, ya está lo suficientemente avanzada como para que los espectadores en general tengan dificultades para distinguir muchos videos falsos de la realidad, y ha proliferado hasta el punto de estar al alcance de casi cualquier persona que tenga un teléfono inteligente, sin necesidad de ser especialista.

"Una vez que el punto de entrada es tan bajo que no requiere ningún esfuerzo, y una persona poco sofisticada puede crear un vídeo pornográfico ultrafalso muy sofisticado y no consentido, ese es el punto de inflexión", dijo Adam Dodge, abogado y fundador de la empresa de seguridad en línea EndTab.

"Ahí es donde empezamos a tener problemas", añadió.

Muchos activistas de la seguridad en línea, investigadores y desarrolladores de software afirman que la clave está en garantizar el consentimiento de quienes son simulados, aunque esto es más fácil de decir que de hacer. Algunos abogan por adoptar un enfoque más estricto en lo que respecta a la pornografía sintética, dado el riesgo de abuso.

La pornografía ultrafalsa no consentida representó el 96% de los más de 14.000 vídeos deepfake publicados en línea, según un informe de 2019 de Sensity, una empresa que detecta y supervisa los medios sintéticos. Añadió que el número de vídeos deepfake en línea se duplicaba aproximadamente cada seis meses.

Aplicación eliminada

ExoClick, la red de publicidad en línea que fue utilizada por la aplicación "Make deepfake porn in a sec" (Fabrica porno ultrafalso en un santiamén), dijo a Reuters que no estaba familiarizada con este tipo de software de intercambio de rostros de inteligencia artificial.

La empresa señaló que había suspendido la publicidad de la aplicación y que no promovería la tecnología de intercambio de rostros de forma irresponsable.

"Se trata de un tipo de producto nuevo para nosotros", dijo Bryan McDonald, jefe de cumplimiento de normas publicitarias de ExoClick, que, al igual que otras grandes redes publicitarias, ofrece a los clientes un panel de sitios que pueden personalizar ellos mismos para decidir dónde colocar los anuncios.

No se menciona el posible uso pornográfico de la aplicación en su descripción en la App Store de Apple o en la Play Store de Google, donde está disponible para cualquier persona mayor de 12 años.

Apple dijo que no tenía ninguna norma específica sobre las aplicaciones de ultrafalso, pero que sus directrices más amplias prohibían las aplicaciones que incluyeran contenidos difamatorios, discriminatorios o que pudieran humillar, intimidar o dañar a alguien.

Google no respondió a las solicitudes de comentarios.

Tras ser contactado por Reuters sobre los anuncios de "Deepfake porn" en sitios para adultos, Google retiró temporalmente la página de Play Store de la aplicación, que había sido calificada como E, o para todos. La página fue repuesta después de unas dos semanas, clasificada como T -para adolescentes debido al "contenido sexual"-.

Filtros y marcas de agua

Algunas aplicaciones, por ejemplo, solo permiten a los usuarios intercambiar imágenes en escenas preseleccionadas o exigen la verificación de la identidad de la persona que se intercambia, o usan la inteligencia artificial para detectar las cargas pornográficas, aunque estas medidas no siempre son eficaces.

Reface es una de las aplicaciones de intercambio de rostros más populares del mundo, que ya ha atraído más de 100 millones de descargas en todo el mundo desde 2019, en las que se anima a los usuarios a intercambiar rostros con celebridades, superhéroes y personajes de memes para crear divertidos videoclips.

La compañía, que tiene su sede en Estados Unidos, dijo a Reuters que estaba usando la moderación automática y humana del contenido, incluyendo un filtro de pornografía, además de tener otros controles para evitar el mal uso, incluyendo el etiquetado y las marcas de agua visuales para marcar los videos como sintéticos.

¿Es posible reconocer estos videos?

Mientras los países siguen debatiendo su regulación, expertos insisten en la importancia de la cibereducación y del desarrollo de programas que los identifiquen.

El experto en ciberseguridad Juan David Cardona indica cómo reconocer estos videos:

- Fijarse en la gesticulación de la persona que aparece en el video, ya que en los clips falsos siempre habrá retrasos en los fotogramas o en la voz.

- Identificar movimientos en los que se desplace la imagen sobrepuesta y fijarse si coincide el tono de piel entre la cara y el cuerpo.

- Mirar si la fuente del video es conocida y confiable. Si no lo es, buscar si aparece en otras fuentes.

Compartir: